|

USB�����RAID 5���ۡ�USB�����������ˡ

�����ॻ���뤷�Ƥ��Τǡ�����

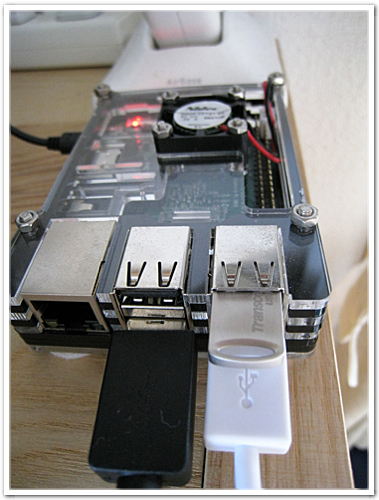

��USB������ɲä���4�ܤ�RAID 5�����ˤ��Ƥߤޤ����ɲä���USB����ϡ������Ѥ��Ƥ���USB��������̤�Ʊ�����礭��ʪ�Ǥ���ɬ�פ�����ޤ������˳��դ�USB�ϥ֤Υݡ��Ȥ˶����Ϥ���ޤ���Raspberry Pi 3���Τ�USB�ݡ��Ȥˤ�2�ݡ��ȶ����Ƥ��ޤ��Τǡ�������USB������ɲä��Ƥߤޤ����ɲä���USB����ϡ������Ʊ��Transcend��64GB USB3����TS64GJF710SP����Amazon�����ॻ����ˡ��Ĥ��Ĥ��ݥ��äȤ��Ƥ��ޤ��ޤ��� ^^;��

������"/boot/config.txt"�ˤϡ�USB�Х��ؤ���ή��������䤹�����max_usb_current=1�ˤϤ��Ƥ���ޤ���Raspberry Pi 3�Ǥϡ���������Ƥ�̵�����Ȥξ���⤢��ˤ⤷��������AC�����ץ��ζ������Ϥ�������ư�����ˤʤ뤫�⤷��ޤ������礨�����Τޤޤǻ�Ƥߤޤ��礦��

����ޤ��ʼ��ϰʲ��Τ褦�ˤʤ�ޤ���

- �ѡ��ƥ������κ������ǥХ���̾����

- RAID���쥤�ؤ��ɲ�

- RAID���쥤�γ�ĥ

- �ե����륷���ƥ���ΰ��ĥ

- ���ȥ饤�ɤȥ��ȥ饤�����κ�Ŭ��

- ��ǧ�Τ���Ƶ�ư

1. �ѡ��ƥ������κ������ǥХ���̾����

��Raspberry Pi 3���Τ�USB�ݡ��Ȥ�TS64GJF710SP���ޤ��ȡ�/dev/sdd�������ޤ������褺�ѡ��ƥ�������������ʤ������ǥХ���̾����ꤷ�ޤ����ѡ��ƥ�����������udev�ˤ��ǥХ���̾����ޤǤ�Ʊ������Ǥ���

# fdisk -l /dev/sdd

Disk /dev/sdd: 58.9 GiB, 63199772672 bytes, 123437056 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disklabel type: dos

Disk identifier: 0x00000000

Device Boot Start End Sectors Size Id Type

/dev/sdd1 2048 123437055 123435008 58.9G fd Linux raid autodetect

# ls -l /dev/usbmd*

lrwxrwxrwx 1 root root 3 8�� 13 11:06 /dev/usbmd -> sdd

lrwxrwxrwx 1 root root 4 8�� 13 11:06 /dev/usbmd1 -> sdd1

|

�����RAID���쥤���ɲä��ޤ���

2.RAID���쥤�ؤ��ɲ�

# umount /media ��ǰ�Τ�������ϰ�öRAID���쥤��ޥ���Ȥ��Ƥ���

# mdadm --manage /dev/md0 --add /dev/usbmd1 ��������USB����ǥХ������ɲä���

# mdadm --misc --detail /dev/md0

/dev/md0:

Version : 1.2

Creation Time : Sat Jul 30 11:24:03 2016

Raid Level : raid5

Array Size : 123369472 (117.65 GiB 126.33 GB)

Used Dev Size : 61684736 (58.83 GiB 63.17 GB)

Raid Devices : 3

Total Devices : 4

Persistence : Superblock is persistent

Update Time : Sat Aug 13 11:10:45 2016

State : clean

Active Devices : 3

Working Devices : 4

Failed Devices : 0

Spare Devices : 1

Layout : left-symmetric

Chunk Size : 256K

Name : RaspberryPi3:0 (local to host RaspberryPi3)

UUID : c26559b7:abb329b4:1960d0d5:7b9c8287

Events : 90

Number Major Minor RaidDevice State

0 8 33 0 active sync /dev/sdc1

1 8 17 1 active sync /dev/sdb1

3 8 1 2 active sync /dev/sda1

4 8 48 - spare /dev/sdd1

|

�����ڥ��Ȥ����ɲä���Ƥޤ��͡�

3. RAID���쥤�γ�ĥ

# mdadm --grow /dev/md0 --raid-disks=4 �������ǥ���������4�����䤷����ĥ����

# mdadm --misc --detail /dev/md0

/dev/md0:

Version : 1.2

Creation Time : Sat Jul 30 11:24:03 2016

Raid Level : raid5

Array Size : 123369472 (117.65 GiB 126.33 GB)

Used Dev Size : 61684736 (58.83 GiB 63.17 GB)

Raid Devices : 4

Total Devices : 4

Persistence : Superblock is persistent

Update Time : Sat Aug 13 11:12:34 2016

State : clean, reshaping

Active Devices : 4

Working Devices : 4

Failed Devices : 0

Spare Devices : 0

Layout : left-symmetric

Chunk Size : 256K

Reshape Status : 0% complete

Delta Devices : 1, (3->4)

Name : RaspberryPi3:0 (local to host RaspberryPi3)

UUID : c26559b7:abb329b4:1960d0d5:7b9c8287

Events : 104

Number Major Minor RaidDevice State

0 8 33 0 active sync /dev/sdc1

1 8 17 1 active sync /dev/sdb1

3 8 1 2 active sync /dev/sda1

4 8 49 3 active sync /dev/sdd1

# cat /proc/mdstat

Personalities : [raid6] [raid5] [raid4]

md0 : active raid5 sdd[4] sdc1[0] sda1[3] sdb1[1]

123369472 blocks super 1.2 level 5, 256k chunk, algorithm 2 [4/4] [UUUU]

[>....................] reshape = 0.3% (205808/61684736) finish=234.7min speed=4363K/sec

unused devices: <none>

|

��RAID���Ȥ߹��ޤ졢RAID���쥤�κƹ������Ϥޤ�ޤ�����������234ʬ������ȸ����Τǡ�®�����¤�夲�Ƥߤޤ���

# cat /proc/sys/dev/raid/speed_limit_min

1000

# cat /proc/sys/dev/raid/speed_limit_max

200000

# echo 500000 >/proc/sys/dev/raid/speed_limit_min

# echo 500000 >/proc/sys/dev/raid/speed_limit_max

|

������ȡ��Ĥ���֤�180ʬ���餤�ˤʤ�ޤ��������ͤ��礭����������ȸ��äƶ�ü��û���ʤ�櫓�ǤϤʤ��褦�Ǥ���

�����ʤ��Τ����֤����뿲�Ǥ⤷�ʤ����Ԥ��ޤ�����λ�������֤ϡ����Τ褦�ˤʤ�ޤ���

# cat /proc/mdstat

Personalities : [raid6] [raid5] [raid4]

md0 : active raid5 sdd1[4] sdc1[0] sda1[3] sdb1[1]

185054208 blocks super 1.2 level 5, 256k chunk, algorithm 2 [4/4] [UUUU]

unused devices: <none>

|

��RAID���������"/etc/mdadm/mdadm.conf"�ˤϹ�������ɬ�פ��ʤ��ͻҤǤ������ƤΤȤ��������Ѥ�äƤ��ޤ���

# mdadm --detail --scan

ARRAY /dev/md0 metadata=1.2 name=RaspberryPi3:0 UUID=c26559b7:abb329b4:1960d0d5:7b9c8287

# tail -1 /etc/mdadm/mdadm.conf

ARRAY /dev/md0 metadata=1.2 name=RaspberryPi3:0 UUID=c26559b7:abb329b4:1960d0d5:7b9c8287

|

4. �ե����륷���ƥ���ΰ��ĥ

��ext4�ե����륷���ƥ�Υ��������ĥ���ޤ���

# resize2fs /dev/md0

resize2fs 1.42.12 (29-Aug-2014)

Please run 'e2fsck -f /dev/md0' first.

|

�����fsck�������ȡ��ޤ���äƤߤޤ�����

# e2fsck -f /dev/md0

e2fsck 1.42.12 (29-Aug-2014)

Pass 1: Checking inodes, blocks, and sizes

Pass 2: Checking directory structure

Pass 3: Checking directory connectivity

Pass 4: Checking reference counts

Pass 5: Checking group summary information

/dev/md0: 97/7716864 files (1.0% non-contiguous), 11404668/30842368 blocks

# resize2fs /dev/md0

resize2fs 1.42.12 (29-Aug-2014)

Resizing the filesystem on /dev/md0 to 46263552 (4k) blocks.

The filesystem on /dev/md0 is now 46263552 (4k) blocks long.

|

5. ���ȥ饤�ɤȥ��ȥ饤�����κ�Ŭ��

��ĥ�Ǥ����äݤ��Τǡ����ȥ饤�ɤȥ��ȥ饤�������Ŭ�����ޤ���

# tune2fs -E stride=64,stripe-width=192 /dev/md0

tune2fs 1.42.12 (29-Aug-2014)

Setting stride size to 64

Setting stripe width to 192

|

UUID���Ѥ�äƤ��ʤ������ǧ���ơ��ޥ���Ȥ��ޤ���

# tune2fs -l /dev/md0 | grep UUID

Filesystem UUID: f8b8beba-56e0-4f91-a717-8f2bc7459453 ��UUID���Ѥ�äƤ��ʤ�

# mount /media

# df -h

�ե����륷�� ������ ���� �Ĥ� ����% �ޥ���Ȱ���

/dev/md0 174G 42G 124G 26% /media

|

6. ��ǧ�Τ���Ƶ�ư

��RAID���쥤�����ȥե����륷���ƥॵ��������ĥ���줿�Τǡ��Ƶ�ư���Ƥ�����פ���Ƥߤޤ���reboot�塢�ʲ����ǧ��

# df -h

# cat /proc/mdstat

# mdadm --misc --detail /dev/md0

/dev/md0:

Version : 1.2

Creation Time : Sat Jul 30 11:24:03 2016

Raid Level : raid5

Array Size : 185054208 (176.48 GiB 189.50 GB)

Used Dev Size : 61684736 (58.83 GiB 63.17 GB)

Raid Devices : 4

Total Devices : 4

Persistence : Superblock is persistent

Update Time : Sat Aug 13 20:10:25 2016

State : clean

Active Devices : 4

Working Devices : 4

Failed Devices : 0

Spare Devices : 0

Layout : left-symmetric

Chunk Size : 256K

Name : RaspberryPi3:0 (local to host RaspberryPi3)

UUID : c26559b7:abb329b4:1960d0d5:7b9c8287

Events : 927

Number Major Minor RaidDevice State

0 8 49 0 active sync /dev/sdd1

1 8 33 1 active sync /dev/sdc1

3 8 17 2 active sync /dev/sdb1

4 8 1 3 active sync /dev/sda1

|

����ʤ��ͻҤǤ��Τǡ��ʾ�Ǻ�Ȥϴ�λ��

�����˺Ƶ�ư����С�®�����¡�"/proc/sys/dev/raid/speed_limit_min", "/proc/sys/dev/raid/speed_limit_max"�ˤϥꥻ�åȤ���ޤ���

|