|

USB�����RAID 5���ۡ�USB����μ�̿������

ʣ����USB���꤬Ʊ���˲��줿�ꤷ�ʤ��褦ͽ�ɺ���֤��Ƥߤ�

0. ���Τ���ʻ���Τ���

�����ߤ� 64GB USB����4�ܤ�RAID 5�������Ƥ��ޤ���

# cat /proc/mdstat

Personalities : [raid6] [raid5] [raid4]

md0 : active raid5 sdd1[0] sda1[4] sdb1[3] sdc1[1]

185054208 blocks super 1.2 level 5, 256k chunk, algorithm 2 [4/4] [UUUU]

unused devices: <none>

# mdadm --detail /dev/md0

/dev/md0:

Version : 1.2

Creation Time : Sat Jul 30 11:24:03 2016

Raid Level : raid5

Array Size : 185054208 (176.48 GiB 189.50 GB)

Used Dev Size : 61684736 (58.83 GiB 63.17 GB)

Raid Devices : 4

Total Devices : 4

Persistence : Superblock is persistent

Update Time : Thu Sep 1 20:15:38 2016

State : clean

Active Devices : 4

Working Devices : 4

Failed Devices : 0

Spare Devices : 0

Layout : left-symmetric

Chunk Size : 256K

Name : RaspberryPi3:0 (local to host RaspberryPi3)

UUID : c26559b7:abb329b4:1960d0d5:7b9c8287

Events : 1027

Number Major Minor RaidDevice State

0 8 49 0 active sync /dev/sdd1

1 8 33 1 active sync /dev/sdc1

3 8 17 2 active sync /dev/sdb1

4 8 1 3 active sync /dev/sda1

|

��Number 0, 1, 3 �ϰ��ˤޤȤ�ƹ��������ꥢ���ֹ��ˤ�ƶᤤ���Ȥ��顢Ʊ����¤���åȤ����ؤ�Ʊ��������¤���줿ʪ�Ȼפ��ޤ���Number 4 �Τ߸夫���ɲä�����ΤǤ����ʲ��� Number 2 ������Ǥ���Τ�����������

�����⤽��RAID�ϡ��������Ƥ���ǥХ����ˤϸ��κ������ꡢ�ξ㤬ȯ����������ˤϥХ�Ĥ������뤳�Ȥ������ˤ��Ʋ�������������Ƥ��ޤ���HDD �ʤ�Ф��������Ϥ��������������ȸ����ޤ����ʤ���Ǥ�Ʊ����¤���åȤ� HDD�μ�̿�϶�ʤ뷹���ˤ��롣���Τ��ᡢRAID�������� HDD�Ϥ������ٻ����餷�ƹ��������������ޤ����Ȥ���Ƥ��롣�ˤ�������USB����ξ������ʼ�̿�ϡ��ե�å������ε�Ͽ����ʥ��ꥻ��ˤ��Ф�����߲���ȡ�����ν��߲����ã�������ꥻ������ؤ��뤿���;����ꥻ���̤����ޤ�ˤ������Ū�ʤ�ΤǤ�������Υ��ꥻ��ؤν��ߤ����椷�ʤ��褦���Τ˽��ߤ�ʿ�Ѳ��������ʼ�̿���Ф���������٥�Ȥ������Ȥߤ⡢����������ʤ��ۤʤ�С��ۤʤ륢�르�ꥺ��ʤ��Τ�����ϳ���¤��������õ����ѤˤʤäƤ����ꤹ��ˤ����Ѥ���Ƥ��뤳�ȤǼ�̿����������ȹͤ����ޤ���������Ʊ���������Ʊ�����ʤǤ���м�̿����������ȤϹͤ��ˤ����Ǥ����ʤޤ��ǿͤ��Ǥ�����������

���ޤ���RAID 5�ǤϽ���ǡ���������������ʬ�䤷��ʣ���ΥǥХ�����ʬ�����ƽ��ߤޤ������κݡ�1��ˤϥ����å����ब���ޤ�ޤ����������å�����˻��Ѥ�����̤�¾�ΥǥХ�����Ʊ���Ϥ��Ǥ����Ĥޤ���ߤ���٤ϤɤΥǥХ������ؤ�Ʊ���Ϥ��ǡ�ͣ�����������dz�꤭��ʤ��ä�;���ʬ�������ǥХ����ˤ�äưۤʤ뤫�⤷��ʤ��ȸ��ä����٤��ȹͤ����ޤ���

������ϡ����Τ褦������Ʊ����̿�ΥǥХ�����RAID�ǥХ����ι����ǥХ����Ȥ���Ʊ���˻��Ѥ��Ϥᡢ�ƥǥХ�����Ʊ����٤�Ϳ��³���Ƥ���Ȥ����櫓�Ǥ��͡����Τޤ��Ѥ�³���Ƥ����Ʊ���˼�̿��ޤ���ǥХ�����ȯ�����Ƥⲿ���ԻĤǤϤʤ��櫓�Ǥ���RAID 5��1��θξ�Ǥ���Хǡ��������ȤˤϤʤ�ޤ���ʣ���椬�ξ㤹��Х����ॻ�åȡ��ǡ����ϼ���졢����Ǥ��ʤ��ʤ�ޤ���

�������ǡ�RAID�������Ƥ��� USB����ǥХ����˸ΰդ˼�̿�����뤳�Ȥǡ�ʣ���ΥǥХ�����Ʊ���˸ξ㤹��Ȥ������֤�ͽ�ɤ������ȹͤ��ޤ���������� USB������̿������褦�ʺ�ȤǤϤʤ����ᤷ�����ʸΰդ�;̿�����ȤȤʤ�ޤ���

�ʤ���ʳ��ˤ� USB����θξ㤫�����줹���ȤΥ�ϡ�����Ȥ�����̣�⤢��ޤ��͡���

����ȼ��Ȥ��Ƥϰʲ��Τ褦�ˤʤ�ޤ���

- �Хå����å���

/dev/md0��ޥ����

- 1���USB�ǥХ�����ξ㰷���ˤ���RAID�����ǥХ������鳰��

- ������USB����˽�����٤�����㤨�Х٥���ޡ����䡢���ΰ�ؤΥ������ߤʤɡ�

- USB����˥ѡ��ƥ�������ƺ�������RAID�����ǥХ������Ȥ߹���RAID��ƹ�������

- RAID�κƹ�������λ�����顢����USB�ǥХ����ˤĤ���Ʊ���褦��3��5��»ܤ���

������Ǻǽ��RAID��������3��˼�̿����������褦�ˤʤ�Ȼפ��ޤ�����Number 0, 1 ����� Number 3, 4 ������Ĺ���ˤʤ롣Number 3 �� 4 �ϻ��ѳ��Ϥ���������ʬ������̿���������Ƥ���ȴ��Ԥ��롣��

1. �Хå����å���

��������ǤϤ���ޤ�����RAID�ϥХå����åפ˺ߤ餺�פϾQ�Ǥ����ޤ��ƺ����RAID�����ǥХ������ƾ�Ĺ�����ʤ����֤ˤ���Τǡ����δ֤�USB���꤬1��Ǥ�ξ㤹��Хǡ��������ȤȤʤ�ޤ������Τ��ᡢ������ˤ�RAID����¸���Ƥ���ǡ����ΥХå����åפ�������Ƥ����ޤ���

2. /dev/md0��ޥ����

���ޥ���Ȥ����ޤޤǤ��Ȥϲ�ǽ��ư����³�����ޤξ㤷���ǥХ��������褦�ʳ����ݼ餬��ǽ�ˤǤϤ���ޤ����������Τ���ˤϥ���ޥ���Ȥ��Ƥ����������ɤ��Ǥ��礦��

�������ξ���/dev/md0��/media�˥ޥ���Ȥ��Ƥ���Τǡ�

�Ȥ��ƥ���ޥ���Ȥ��Ƥ����ޤ���

3. 1���USB�ǥХ�����ξ㰷���ˤ���RAID�����ǥХ������鳰��

���ǽ�� Number 0 �ΥǥХ�����ξ�ˤ��Ƥߤޤ����ǥХ���̾��/dev/sdd1�ˤʤäƤ��ޤ�����udev �ǥǥХ���̾����ꤷ�Ƥ���ޤ��ơ������/dev/usbma1�Ȥ���̾���ΥǥХ����ˤʤ�ޤ���

��/dev/sd*�Ȥ����ǥХ���̾�ϡ�OS���ǥХ�����ǧ��������˳�꿶��Τǡ��֡��Ȥ��٤��Ѥ�äƤ��ޤ��ΤǤ������Τ��ᡢ���ߤϡ�����ʾ��֤ˤʤäƤ��ޤ�����

# ls -l /dev/usb*

lrwxrwxrwx 1 root root 3 8�� 28 17:17 /dev/usbma -> sdd

lrwxrwxrwx 1 root root 4 8�� 28 17:17 /dev/usbma1 -> sdd1

lrwxrwxrwx 1 root root 3 8�� 28 17:17 /dev/usbmb -> sdc

lrwxrwxrwx 1 root root 4 8�� 28 17:17 /dev/usbmb1 -> sdc1

lrwxrwxrwx 1 root root 3 8�� 28 17:17 /dev/usbmc -> sdb

lrwxrwxrwx 1 root root 4 8�� 28 17:17 /dev/usbmc1 -> sdb1

lrwxrwxrwx 1 root root 3 8�� 28 17:17 /dev/usbmd -> sda

lrwxrwxrwx 1 root root 4 8�� 28 17:17 /dev/usbmd1 -> sda1

|

����̿�����ꤿ���Τϡ��ǽ��RAID��������3��Ǥ��������/dev/usbma, /dev/usbmb, /dev/usbmc��3��ˤʤ�ޤ����ǽ��/dev/usbma�ϸ���/dev/sdd�ˤʤäƤ���Ȥ����櫓�Ǥ����ǥХ���̾����ꤷ�Ƥ������������ǡ�����ʤ�䤳���������Ǥ����оݤ� USB���������Ǥ��ޤ���

���ȸ������Ȥǡ��褺��/dev/usbma��ξ㰷���ˤ��Ƥߤޤ���

# mdadm --fail /dev/md0 /dev/usbma1

mdadm: set /dev/usbma1 faulty in /dev/md0

# mdadm --detail /dev/md0

/dev/md0:

Version : 1.2

Creation Time : Sat Jul 30 11:24:03 2016

Raid Level : raid5

Array Size : 185054208 (176.48 GiB 189.50 GB)

Used Dev Size : 61684736 (58.83 GiB 63.17 GB)

Raid Devices : 4

Total Devices : 4

Persistence : Superblock is persistent

Update Time : Sat Sep 3 09:13:37 2016

State : clean, degraded

Active Devices : 3

Working Devices : 3

Failed Devices : 1

Spare Devices : 0

Layout : left-symmetric

Chunk Size : 256K

Name : RaspberryPi3:0 (local to host RaspberryPi3)

UUID : c26559b7:abb329b4:1960d0d5:7b9c8287

Events : 1029

Number Major Minor RaidDevice State

0 0 0 0 removed

1 8 33 1 active sync /dev/sdc1

3 8 17 2 active sync /dev/sdb1

4 8 1 3 active sync /dev/sda1

0 8 49 - faulty /dev/sdd1

|

��1��ξ㤷�����֤ˤʤ�ޤ���(*1)�������RAID�����ǥХ������鳰���ޤ���

# mdadm --remove /dev/md0 /dev/usbma1

mdadm: hot removed /dev/usbma1 from /dev/md0

# mdadm --detail /dev/md0

/dev/md0:

Version : 1.2

Creation Time : Sat Jul 30 11:24:03 2016

Raid Level : raid5

Array Size : 185054208 (176.48 GiB 189.50 GB)

Used Dev Size : 61684736 (58.83 GiB 63.17 GB)

Raid Devices : 4

Total Devices : 3

Persistence : Superblock is persistent

Update Time : Sat Sep 3 09:16:52 2016

State : clean, degraded

Active Devices : 3

Working Devices : 3

Failed Devices : 0

Spare Devices : 0

Layout : left-symmetric

Chunk Size : 256K

Name : RaspberryPi3:0 (local to host RaspberryPi3)

UUID : c26559b7:abb329b4:1960d0d5:7b9c8287

Events : 1030

Number Major Minor RaidDevice State

0 0 0 0 removed

1 8 33 1 active sync /dev/sdc1

3 8 17 2 active sync /dev/sdb1

4 8 1 3 active sync /dev/sda1

# cat /proc/mdstat

Personalities : [raid6] [raid5] [raid4]

md0 : active raid5 sda1[4] sdb1[3] sdc1[1]

185054208 blocks super 1.2 level 5, 256k chunk, algorithm 2 [4/3] [_UUU]

unused devices: <none>

|

���տޤ����Ȥ��ꡢ��Ƭ�ΥǥХ����������ǥХ������鳰����Ƥ��ꡢ�����degraded�˾��֤�ư��Ƥ��ޤ�������Ǹξ㰷���ˤ��� USB�����ϥ֤���ȴ���Ƥ�����פʤϤ��Ǥ���

��USB�����ϥ֤���ȴ���Ƥߤơ��⤦���ٳ�ǧ��������ȴ��USB�����ְ㤨�Ƥ����顢[_U_U]�ʤ�ƾ��֤ˤʤäƤ���ΤǤϤʤ����Ȼפ��������᤻������פ��⤷��ʤ������ǡ��������Ȥˤʤ��ǽ�����⤤�Ȼפ����ݤ������Ƥʤ����ɡ�������

# cat /proc/mdstat

Personalities : [raid6] [raid5] [raid4]

md0 : active raid5 sda1[4] sdb1[3] sdc1[1]

185054208 blocks super 1.2 level 5, 256k chunk, algorithm 2 [4/3] [_UUU]

unused devices: <none>

|

������פǤ��͡�

4. ������USB����˽�����٤���

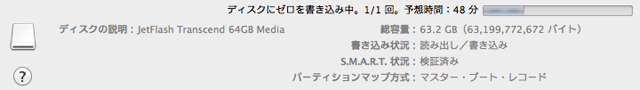

��������USB����� Mac��USB�ݡ��Ȥ��ޤ��ޤ���Mac�Ǥϻ��ѤǤ��ʤ��ѡ��ƥ������ˤʤäƤ���Τǡ���������ե����ޥåȤ��Ƥ��ޤ��ޤ�������ϡ���������Ʊ����MS-DOS��FAT�ˡפ˥ե����ޥåȤ��ʤ����ƥޥ���Ȥ����ޤ�����

������� USB�������Ȥ�̵�����֤ˤʤ�ޤ��������ºݤˤϥ��ꥻ���˵�Ͽ����Ƥ���ǡ����Ͼõ�줺�˻ĤäƤ��ޤ����ѡ��ƥ������κƺ����ȥե����ޥåȤǡ�OS��ե����뤬̵�����֤ˤʤä������Ǥ�����������ºݤ�I/O��٤��ƥ��ꥻ��ν�����Ԥ��ޤ�������ϥ٥���ޡ������äƤߤޤ�����

�����ޤ��̿���ꤹ���Ƥ⺤��Τ�Ĺ���֤Ϥ�äƤ��ޤ���Write��14MB/s��Read��36MB/s���٤���ǽ�Ǥ������勵���� MacPro ��USB 2.0�ʤΤǡ��ޤ�����ʥ��Ǥ��礦��

5. USB����˥ѡ��ƥ�������ƺ�������RAID�����ǥХ������Ȥ߹���RAID��ƹ�������

��Mac ���� USB�����ȴ���ơ�Raspberry Pi �� USB�ϥ֤��ᤷ�ޤ�������Ȱ�����Ʊ�� USB�ǥХ���̾��ɽ��ޤ���

# ls -l /dev/usbma*

lrwxrwxrwx 1 root root 3 9�� 3 09:49 /dev/usbma -> sdd

lrwxrwxrwx 1 root root 4 9�� 3 09:49 /dev/usbma1 -> sdd1

|

��RAID���Ȥ߹��ि��ˡ�������ä��Τ�Ʊ���褦�˥ѡ��ƥ���������ľ���ޤ���

# fdisk /dev/usbma

��������Ʊ�����ʤΤǾ�ά��

# fdisk -l /dev/usbma

Disk /dev/usbma: 58.9 GiB, 63199772672 bytes, 123437056 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disklabel type: dos

Disk identifier: 0x00000000

Device Boot Start End Sectors Size Id Type

/dev/usbma1 2048 123437055 123435008 58.9G fd Linux raid autodetect

|

���ѡ��ƥ���������ľ�����Τǡ����ΥǥХ�����RAID���Ȥ߹��ߤޤ���

# mdadm --add /dev/md0 /dev/usbma1

mdadm: added /dev/usbma1

# mdadm --detail /dev/md0

/dev/md0:

Version : 1.2

Creation Time : Sat Jul 30 11:24:03 2016

Raid Level : raid5

Array Size : 185054208 (176.48 GiB 189.50 GB)

Used Dev Size : 61684736 (58.83 GiB 63.17 GB)

Raid Devices : 4

Total Devices : 4

Persistence : Superblock is persistent

Update Time : Sat Sep 3 10:10:52 2016

State : clean, degraded, recovering

Active Devices : 3

Working Devices : 4

Failed Devices : 0

Spare Devices : 1

Layout : left-symmetric

Chunk Size : 256K

Rebuild Status : 0% complete

Name : RaspberryPi3:0 (local to host RaspberryPi3)

UUID : c26559b7:abb329b4:1960d0d5:7b9c8287

Events : 1032

Number Major Minor RaidDevice State

5 8 49 0 spare rebuilding /dev/sdd1

1 8 33 1 active sync /dev/sdc1

3 8 17 2 active sync /dev/sdb1

4 8 1 3 active sync /dev/sda1

|

��RAID���Ȥ߹��ޤ�ƺƹ������Ƥ��ޤ����ƹ����ˤ�

# cat /proc/mdstat

Personalities : [raid6] [raid5] [raid4]

md0 : active raid5 sdd1[5] sda1[4] sdb1[3] sdc1[1]

185054208 blocks super 1.2 level 5, 256k chunk, algorithm 2 [4/3] [_UUU]

[>....................] recovery = 1.1% (707180/61684736) finish=113.1min speed=8981K/sec

unused devices: <none>

|

113ʬ������ȸ����Τǡ�����®�٤�夲�Ƥߤޤ�������

# echo 500000 >/proc/sys/dev/raid/speed_limit_min

# echo 500000 >/proc/sys/dev/raid/speed_limit_max

# cat /proc/mdstat

Personalities : [raid6] [raid5] [raid4]

md0 : active raid5 sdd1[5] sda1[4] sdb1[3] sdc1[1]

185054208 blocks super 1.2 level 5, 256k chunk, algorithm 2 [4/3] [_UUU]

[>....................] recovery = 2.5% (1603116/61684736) finish=109.5min speed=9140K/sec

unused devices: <none>

|

����®���ʤ�ʤ��Ǥ��͡��ޤ������䡢���Τޤ����֤��Ƥ����ޤ��礦�������餯 3���USB���꤫���ɤ߽Ф��ƽ��������ǡ������Ȥ߹���� 1���USB����ˤɤ�ɤ����Ǥ��뤳�ȤǤ��礦����������Ǥ�빽����٤ˤʤäƤ���Ȼפ��ޤ��������1����USB����μ�̿���뤳�Ȥ��Ǥ��ޤ�����

6. RAID�κƹ�������λ�����顢����USB�ǥХ����ˤĤ���Ʊ���褦��3��5��»ܤ���

���ƹ�������λ�����顢����USB�ǥХ���(/dev/usbmb)�ˤĤ��Ƥ�Ʊ����Ȥ�Ԥ��ޤ�����ɬ���ƹ����δ�λ��˹Ԥ����ȡ��ƹ�����λ���ˤ�äƤ��ޤ��ȡ��ǡ��������Ȥˤʤ�Τ����ա��ˤ��ΤȤ�����˹Ԥä��ΤȤ��̤���٤ˤ��뤫����٤�����֤��Ѥ��褦�ˤ��ޤ�������USB�ǥХ����Ǥϡ����Τ����ߤ���Ȥ������פ��㤷��������٤��Ƥߤޤ�����64GB�Υ������ߤ�1���ְʾ夫����ޤ�����

��/dev/md0��ޥ���Ȥ���RAID�����ǥХ����μ�̿�������Ȥϴ�λ�Ǥ���

(*1)������������Ϥ��Ƥ��ޤ�����

Subject: Fail event on /dev/md0:RaspberryPi3

This is an automatically generated mail message from mdadm

running on RaspberryPi3

A Fail event had been detected on md device /dev/md0.

It could be related to component device /dev/sdd1.

Faithfully yours, etc.

P.S. The /proc/mdstat file currently contains the following:

Personalities : [raid6] [raid5] [raid4]

md0 : active raid5 sdd1[0](F) sda1[4] sdb1[3] sdc1[1]

185054208 blocks super 1.2 level 5, 256k chunk, algorithm 2 [4/3] [_UUU]

unused devices: <none>

|

|